Konsulent: Vi må ikke overlade etikken til robotterne

DEBAT: Vi må ikke overlade etiske spørgsmål til teknologien. Det kan ende i både race-, køns- og aldersdiskrimination, skriver Troels Agergaard Jacobsen fra Accenture.

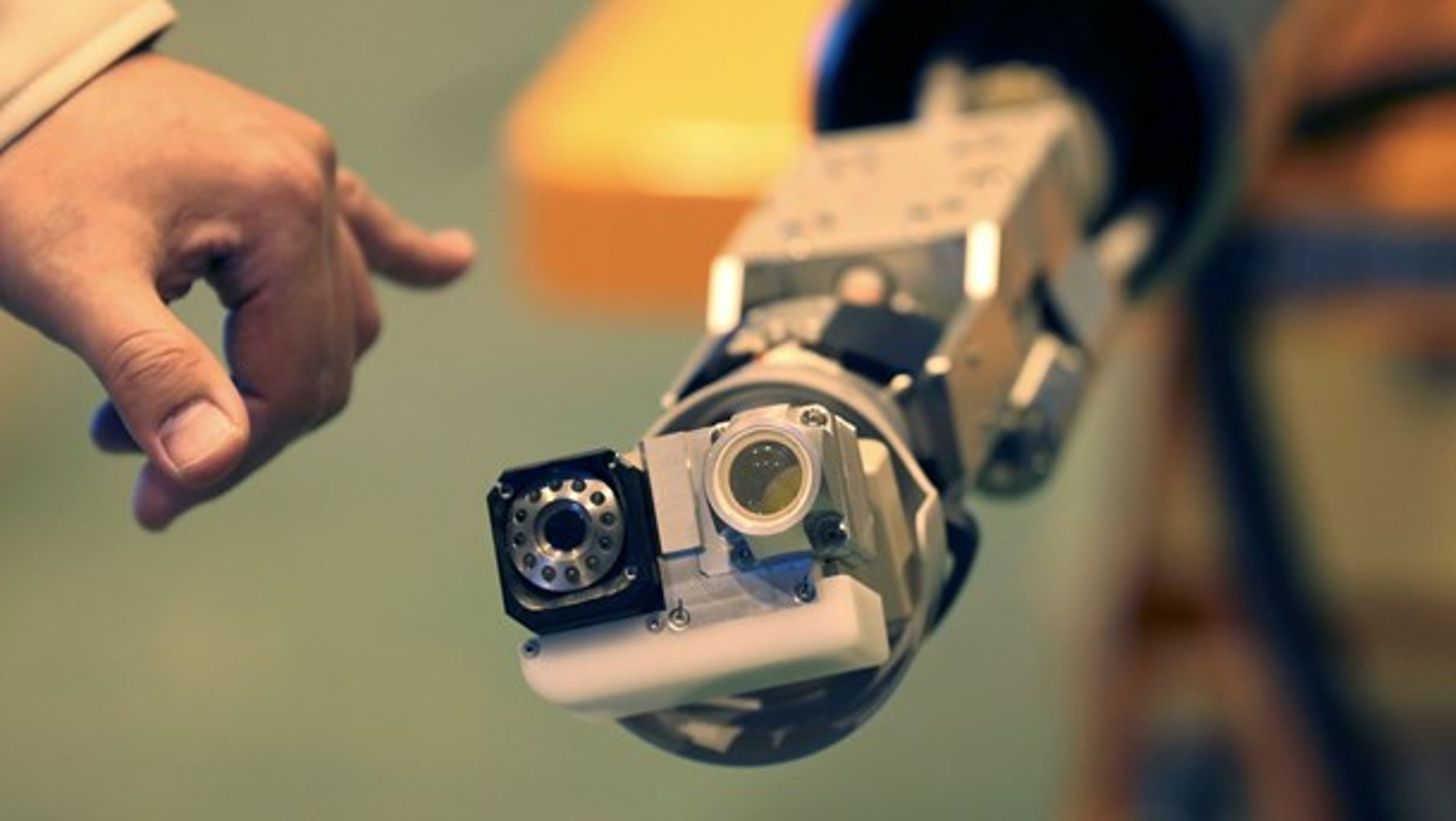

Foto: Koji Sasahara/AP/Ritzau Scanpix

Frederik Lange

RedaktionsassistentAf Troels Agergaard Jacobsen

Technology Strategy Lead, Accenture

Forestil dig, at du sidder i en selvkørende bil. Foran vælter en cyklist pludselig ud på vejbanen, og til højre i rabatten går en børnehave.

Hvad gør bilens computer nu? Grundlaget for den beslutning skal udviklerne af de selvkørende biler allerede nu tage stilling til.

Alle organisationer, der forfølger mulighederne i kunstig intelligens, er nødt til at tage højde for de negative konsekvenser, som etiske forsømmelser eller fejl vil føre med sig på sigt.

Skriv til os på [email protected].

For fejlene kommer til at ske. Nu handler det om at få sat robotterne på plads, opdrage dem til retfærdighed, så vi minimerer fejl og misforståede hensyn i algoritmerne på langt sigt.

Uheldige beslutninger

For nyligt offentliggjorde SAP, at de har etableret et etisk råd for kunstig intelligens, og flere andre store virksomheder følger trop. Det er skridt i den rigtige retning.

En amerikansk fængselsservice har for nyligt anvendt en algoritme til at afgøre, om de indsatte var kvalificerede til prøveløsladelse. Algoritmen viste desværre en tydelig fordom mod særlige etniske samfundsgrupper.

Troels Agergaard Jacobsen

Technology Strategy Lead, Accenture

Kunstig intelligens vil potentielt komme til at træffe livsforandrende beslutninger om arbejdskraft, matchmaking eller finansielle emner, og teknologien vil måske utilsigtet basere beslutningerne på skjulte fordomme i algoritmen eller datasættet.

Når den kunstige intelligens fortsætter med at lære, kan den udtrykke disse fordomme med uheldige og etisk uacceptable beslutninger.

For eksempel har en amerikansk fængselsservice for nyligt anvendt en algoritme til at afgøre, om de indsatte var kvalificerede til prøveløsladelse. Algoritmen viste desværre en tydelig fordom mod særlige etniske samfundsgrupper.

Sæt din robot på plads

Mine kollegaer i USA har for nyligt udviklet et digitalt ’Fairness Tool’, hvor de identificerer og fjerner al koordineret påvirkning i de datasæt, der anvendes til at træne algoritmerne, som kan lede til et fordomsfuldt resultat, for eksempel i forhold til køn, race eller alder.

Værktøjer som disse bliver nødvendige i tillæg til etiske udvalg ude i virksomhederne, fordi fordomme i datasæt er komplicerede og ikke altid baserer sig på de input, som vi har givet dem.

Men vi må aldrig forvente, at der kommer en samlet teknologisk ’knap’, der kan løse de etiske udfordringer – løsningen er langt hen ad vejen en kombination af velovervejede digitale løsninger og etiske udvalg.

Og selvom det kan forekomme tidligt for mange virksomheder, så er det nu, vi skal vise robotterne, hvor skabet skal stå, så vi har den rette platform at bygge videre på.